什么是AI大模型如何理解AI大模型?

AI大模型就是Foundation Model(基础模型),指通过在大规模宽泛的数据上进行训练后能适应一系列下游任务的模型。

谷歌于2018年10月发布的BERT模型是最为典型的基础模型,它利用BooksCorpus和英文维基百科里纯文字的部分,无须标注数据,用设计的两个自监督任务来做训练,训练好的模型通过微调在11个下游任务上实现最佳性能。

OpenAI在2020年5月发布的GPT-3则是一个自回归语言模型,具有1750亿参数,在互联网文本数据上训练得到的这一基础模型,可以使用提示的例子完成各式各样的任务,使用描述任务(如“把英文翻译成法语:”)加一个示例(如“sea otter => loutre de mer”),再给一个prompt提示(如“cheese =>”),GPT-3模型即可生成cheese对应的法文。这类模型正在成为主流的AI范式。

如何判断模型是否属于大模型?

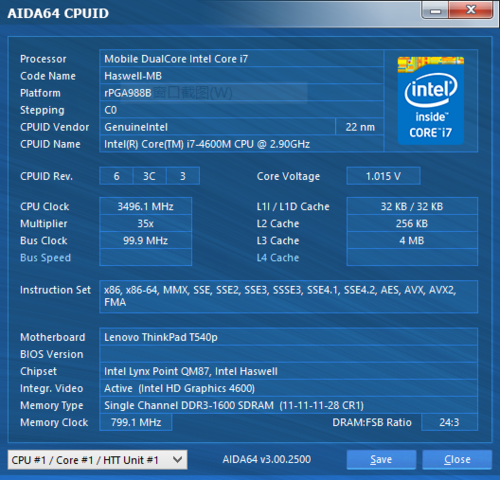

参数量仅是AI大模型的单一表征,模型深度、网络结构也可判断是否属于AI大模型,只是相对不够直观。

文继荣:的确,AI大模型一开始给人的第一印象就是参数量大,从最开始GPT-1的1.17亿到GPT-3的1750亿,参数量确实在以突破性的速度提升。但是除了大的参数量,我们还希望大模型具备什么样的特点呢?

我认为,可以回归我们的大脑,观察我们的自身。我们的大脑是一个大模型,它有860亿个神经元和125万亿个突触,大脑在这个基础上彰显出的基础认知能力令我们惊叹。它能够同时高效地处理不同感官的信息并执行差异巨大的认知任务。

因此,对于AI大模型而言,我认为我们不仅期望它的参数量巨大,大模型也应同时具备多种模态信息的高效理解能力、跨模态的感知能力以及跨差异化任务的迁移与执行能力等。